Mozilla hat Firefox 148 für Windows, Apple macOS und Linux veröffentlicht. Dieser Artikel fasst die wichtigsten Neuerungen zusammen – wie immer auf diesem Blog weit ausführlicher als auf anderen Websites.

Download Mozilla Firefox für Microsoft Windows, Apple macOS und Linux

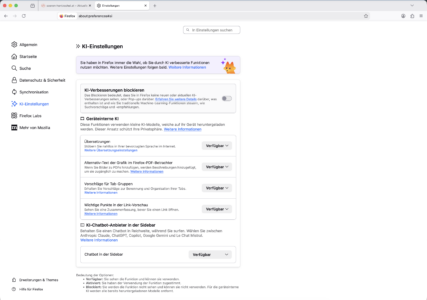

„Kill Switch” für KI-Funktionen

Künstliche Intelligenz (KI) ist ein Thema, welches mittlerweile omnipräsent ist. Die einen lieben es, andere möchten am liebsten gar nichts damit zu tun haben. Sämtliche KI-Funktionen in Firefox waren vom ersten Tag an optional. Außerdem setzt Mozilla für eine verbesserte Privatsphäre bevorzugt auf lokale KI anstelle von Cloud-basierten KI-Lösungen.

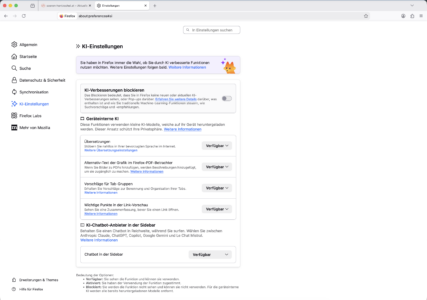

Um die Verwaltung von KI-Funktionen noch einfacher zu machen, hat Mozilla die Firefox-Einstellungen um einen zusätzlichen Bereich mit der Bezeichnung „KI-Einstellungen” erweitert. Dieser neue Bereich bietet einen Ort, um alle KI-Funktionen zentral zu steuern. Außerdem gibt es für jede Einstellung einen kurzen Erklärungstext sowie einen Link mit detaillierten Informationen.

Darüber hinaus bietet Firefox einen globalen Schalter zum Ein- und Ausschalten von KI-Funktionen an – welcher auch alle zukünftigen KI-Features abschaltet. Andere Medien hatten in diesem Zusammenhang häufig von einem sogenannten „Kill Switch” gesprochen.

Firefox 148 bietet Einstellungen für fünf KI-basierte Funktionen an: Übersetzungen von Websites in andere Sprachen, die Generierung von Alternativtexten beim Hinzufügen von Bildern in PDF-Dateien, um deren Barrierefreiheit zu verbessern, Vorschläge für andere Tabs sowie Beschriftungen für Tab-Gruppen, KI-Zusammenfassungen für die Link-Vorschau sowie diverse Chatbots in der Sidebar. Nutzer, die Firefox auf Deutsch nutzen, sehen lediglich Optionen für die Funktionen, die für Nutzer in deutscher Sprache verfügbar sind, da die anderen Optionen für entsprechende Nutzer ohnehin nicht relevant sind.

Mehr Sicherheit für Firefox-Nutzer

Auch in Firefox 148 wurden wieder mehrere Sicherheitslücken geschlossen. Alleine aus Gründen der Sicherheit ist ein Update auf Firefox 148 daher für alle Nutzer dringend empfohlen.

Sonstige Endnutzer-Neuerungen in Firefox 148

Die Backup-Funktion steht nun auch für Nutzer von Windows 10 zur Verfügung, die Firefox so konfiguriert haben, dass Browserdaten beim Beenden gelöscht werden. Dabei werden die Daten, die beim Beenden von Firefox gelöscht werden sollen, vom Backup ausgeschlossen.

Neben einer vollständigen Website-Übersetzung, welche vollständig lokal arbeitet, bietet Firefox auch die Möglichkeit einer freien Textübersetzung via about:translations an. Diese Seite nutzt nun auch die Oberflächen-Sprache von Firefox, statt immer auf Englisch zu sein, und hat eine Schaltfläche zum Leeren des Feldes für den Originaltext sowie eine Schaltfläche zum Kopieren der Übersetzung erhalten. Außerdem werden jetzt auch Übersetzungen von und nach traditionellem Chinesisch sowie ins Vietnamesische unterstützt.

Verbesserungen aus der Ferne wurden von der Telemetrie-Anforderung entkoppelt. Damit können nun auch ohne aktivierte Telemetrie Verbesserungen zwischen den Updates empfangen werden. Beides lässt sich unabhängig voneinander in den Firefox-Einstellungen aktivieren oder deaktivieren.

Hintergrundbilder auf der Firefox-Startseite funktionieren jetzt auch für Tabumgebungen.

Die Screenreader-Unterstützung für in PDF-Dateien eingebettete mathematische Formeln wurde verbessert.

Verbesserungen der Webplattform

Firefox 148 ist der erste Browser, der die neue Sanitizer API unterstützt, um nicht vertrauenswürdigen HTML-Code zu bereinigen, bevor er in das DOM eingefügt wird.

Die Trusted Types API stellt sicher, dass Eingaben eine vom Benutzer festgelegte Transformationsfunktion durchlaufen haben, bevor sie an eine API weitergeleitet werden, die diese Eingaben möglicherweise ausführt.

Das paste-Kommando kann nun mit Document.execCommand() in Webinhalten und nicht mehr nur in Erweiterungen verwendet werden. Dies unterliegt denselben Sicherheitsüberlegungen wie die Clipboard-API, z. B. der Notwendigkeit einer vorübergehenden Aktivierung und der Bestätigung durch den Benutzer beim Einfügen von Cross-Origin-Inhalten.

Firefox unterstützt nun die CSS-Funktion shape(), mit der reaktionsfähige Freiformformen in Eigenschaften definiert werden können. Im Gegensatz zu path() verwendet sie die Standard-CSS-Syntax, unterstützt verschiedene CSS-Einheiten und erlaubt mathematische Funktionen.

Die Durchstreichung von Text konnte auf hochauflösenden Bildschirmen im Vergleich zu anderen Browsern zu fein dargestellt werden, was in Firefox 148 verbessert worden ist.

Service Worker ermöglichen jetzt auch die Ausführung von WebGPU im Hintergrund, was besonders für Erweiterungen und andere Seiten nützlich ist, die Ressourcen sinnvoll über mehrere Tabs und Zeiträume hinweg gemeinsam nutzen können.

Die Unterstützung für asm.js wurde deaktiviert, da mit WebAssembly seit langer Zeit eine bessere Nachfolge-Technologie zur Verfügung steht.

Dies war nur eine Auswahl. Weitere Verbesserungen der Webplattform und für Erweiterungsentwickler lassen sich wie immer in den MDN Web Docs nachlesen.

Der Beitrag Mozilla veröffentlicht Firefox 148 – inklusive „KI Kill Switch” erschien zuerst auf soeren-hentzschel.at.