In den letzten Tagen gab es eine katastrophale Berichterstattung anderer Websites über eine experimentelle Unterstützung von Privacy Preserving Attribution (PPA) in Firefox 128. Auffällig: Die Websites, die so negativ berichtet haben, sind zu einem großen Teil selbst die größten Profiteure vom Tracking ihrer eigenen Leser – etwas, was es mit PPA nicht geben würde. Dieser Artikel liefert die Fakten, welche andere Websites verschweigen, und erklärt, was es mit Privacy Preserving Attribution wirklich auf sich hat, wieso es hier nicht alleine um Mozilla geht, welche Rolle auch die anderen Browser sowie Let’s Encrypt-Betreiberin ISRG spielen und wieso PPA in Wahrheit gut für den Nutzer ist.

Die Sache mit der Werbung

Ohne Frage ist Werbung auf Websites ein kontroverses Thema. Ob man nun Werbung auf Websites akzeptieren kann oder jede Form von Werbung blockiert: Tatsache ist, dass ein großer Teil des Webs werbefinanziert ist und sich das nicht ändern wird, nur weil ein Teil der Nutzer einen Werbeblocker verwendet. Wie ich bereits in meinem Kommentar zu Werbeblockern vor neun Jahren formuliert hatte:

„Alles hat seinen Preis, auch das, was einen selbst nichts kostet. Ausgaben für Server, Redaktionsräume sowie Redakteure und ja, manche Webseite besitzt sogar tatsächlich die Dreistigkeit, auch etwas verdienen zu wollen. Mir persönlich kann auf jeden Fall kein Leser erzählen, dass er acht Stunden am Tag arbeitet, vielleicht sogar mehr, nur um der guten Sache wegen und kein Geld dafür von seinem Arbeitgeber sehen will. Ein Geschäftsmodell gibt Webseiten die Möglichkeit, den Lesern kostenlos Inhalte in einer Weise anbieten zu können, welche für die Content-Anbieter lukrativ ist. Die Alternative dazu ist es eben nicht, die Inhalte werbefrei anzubieten, die Alternative dazu ist es, die Inhalte gar nicht anzubieten. Denn wieso sollte jemand ein Geschäft, eine Online-Redaktion, irgendetwas aufbauen und ggf. sogar die Verantwortung für viele Menschen und deren Existenzen übernehmen, wenn überhaupt kein eigener Nutzen darin besteht? Das mag edel klingen, geht aber leider vollkommen an der Realität vorbei.“

An dieser Stelle soll keine Moraldebatte über Werbeblocker geführt werden. Wer Werbung blockieren will, soll Werbung blockieren. Das ist hier nicht das Thema. Aber jedem muss klar sein, dass nur weil man selbst Werbung blockiert, dies nichts daran ändert, dass werbefinanzierte Websites weiterhin über Werbung finanziert werden und nicht auf magische Weise plötzlich anders.

Wieso gibt es Tracking und was ist das Problem damit?

Das Schalten von Werbung kostet Geld. Und Werbung, die den potenziellen Käufer nicht interessiert, wird nicht zu einem Kaufabschluss, einer sogenannten „Conversion“, führen. Also versucht man, Werbung möglichst an diejenigen auszuspielen, die sich potenziell eher für das Produkt interessieren, als an der Zielgruppe vorbei. Das verspricht höhere Conversion-Raten und damit mehr Kaufabschlüsse bei gleichem Werbeeinsatz oder den gleichen Umsatz mit weniger Investition in Werbung. Damit das richtig funktioniert, muss der Erfolg der Werbung natürlich auch gemessen werden.

Was erst einmal gut klingt, hat aus Nutzersicht den großen Nachteil, dass diese Personalisierung üblicherweise über sogenanntes „Tracking“ erfolgt. Vereinfacht gesagt bedeutet das, dass Nutzer während des Surfens im Web „verfolgt“ werden, es entstehen „Nutzer-Profile“. Und diese sind teilweise sehr detailliert und können ein umfangreiches Bild vermitteln, welches teilweise so eindeutig ist, dass man leicht aus der Masse hervorsticht und über längere Zeiträume diesen eindeutigen Datensätzen zugeordnet werden kann. Aus Privatsphäre-Sicht des Nutzers ist dies sicher nicht erstrebenswert. Deswegen arbeiten Browserhersteller wie Mozilla seit Jahren daran, den Tracking-Schutz des Browsers immer weiter zu verbessern. Gerade Firefox liefert in sehr regelmäßigen Abständen immer weitere Privatsphäre-Verbesserungen.

Immer nur blockieren hat das Problem nicht gelöst

Nun könnte man auf die Idee kommen, dass wenn Tracking so schlecht ist, Browser doch einfach alle Tracking-Versuche blockieren könnten. Zu glauben, das sei bereits die ganze Antwort auf das Problem, wäre naiv.

Browser wie Firefox unternehmen bereits große Anstrengungen, Tracking zu blockieren. Je schwieriger das Tracking über konventionelle Wege gemacht wird, desto kreativer wird allerdings auch die Werbebranche. Vor Jahren wurde sogar schon damit begonnen, mit HSTS eine Sicherheits-Funktion für Tracking-Zwecke zu missbrauchen. Dass Nutzer Sicherheits-Funktionen abschalten, um die Privatsphäre zu gewährleisten, sollte definitiv nicht das Ziel sein.

Zu bedenken ist außerdem, dass es auch auf Kosten der Website-Kompatibilität geht, je mehr man blockiert. Nicht grundlos bietet Firefox einen Standard- sowie einen strengeren Tracking-Schutz an, der mehr blockiert, dafür aber auch einiges an Problemen auf Websites verursacht. Diesen standardmäßig für alle Nutzer zu aktivieren, wäre nach heutigem Stand nicht möglich, da Firefox-Nutzer so viele Probleme auf Websites hätten, für die aus Sicht vieler Nutzer natürlich Firefox Schuld wäre, dass sie vermutlich zu einem Browser wechseln würden, der diese Probleme nicht hat – vielleicht auch, weil dieser weniger gegen Tracking unternimmt als Firefox.

Um Tracking wirklich nachhaltig zu eliminieren, kann es nur einen Weg geben: Es muss eine Alternative angeboten werden, bei der jeder gewinnt: Nutzer und Werbetreibende. Werbetreibende müssen in der Lage sein, ihre Werbung zielgerichtet auszuspielen und den Erfolg messen zu können. Nutzer müssen sich sicher hinsichtlich ihrer Privatsphäre fühlen können. Nur wenn die Interessen beider Seiten gewahrt bleiben, gibt es eine realistische Chance, Tracking eines Tages tatsächlich zu eliminieren.

„Werbung ist blöd, ich würde auch für Content bezahlen“

Das ist natürlich eine vorbildliche Haltung. Generell sollten Content-Ersteller, deren Inhalte man regelmäßig konsumiert, unterstützt werden. Allerdings sind Menschen mit dieser Einstellung in einer klaren Minderheit. Bezahlmodelle funktionieren realistisch betrachtet nur für einen ganz kleinen Teil aller Websites. Im Allgemeinen ist die Zahlungsbereitschaft der Nutzer für Websites minimal bis nicht existent. In Zeiten, in denen ohnehin alles teurer wird, gilt dies eher mehr als weniger. Und angenommen, mehr Websites würden eine Bezahlung verlangen: Selbst zahlungsbereite Konsumenten dürften wohl eine Grenze haben.

Auch Mozilla hatte mit dem Projekt Firefox Better Web vor vier Jahren mit dem Konzept einer Bezahlversion des Webs experimentiert, welches gegen eine monatliche Zahlung Werbefreiheit auf den teilnehmenden Partnerseiten versprochen hat. Dieses Experiment wurde relativ schnell eingestellt. Und das ist nur ein Beispiel. Versuche, Alternativen zur Werbung zu etablieren, gab es auch von anderen immer wieder. Fakt ist: Bis heute hat sich kein Geschäftsmodell für das Web gefunden, welches eine echte Alternative darstellt. Sogenannte Paywalls oder Bezahlschranken funktionieren im Einzelfall, aber sind keine Lösung für das Web als Ganzes. Zumal es auch der Idee eines offenen Webs widerspricht, wenn der Zugang zu großen Teilen des Webs eben nicht mehr offen ist, sondern bezahlt werden muss. Und es gibt bereits eine erschreckende Tendenz in diese Richtung.

Worum geht es bei Privacy Preserving Attribution (PPA)?

Nun kommen wir endlich zur Privacy Preserving Attribution, PPA. Wie ich bereits im Artikel zu Firefox 128 und damit deutlich vor der aktuellen Debatte beschrieben habe, geht es darum, eine Alternative zu etablieren, welche Tracking überflüssig macht. Werbetreibende sollen relevante Daten erhalten, ohne dass dabei Daten über einzelne Personen gesammelt werden. Im Vergleich zum Tracking ist das aus Sicht des Nutzers ohne jeden Zweifel die bessere Option.

Konkret geht es hier um die Attribution, sprich eine Zuordnung, wie oft eine bestimmte Werbung gesehen wurde und zu einem Kaufabschluss geführt hat. Ohne eine solche Zuordnung wüssten Werbetreibende nicht, ob ihre Werbung funktioniert oder nicht. Diese Information ist aber von elementarer Bedeutung und Werbetreibende gehen jeden technisch möglichen Weg, diese Information zu erhalten. Deswegen ist die Idee, diese Information in einer Weise bereitzustellen, welche die Privatsphäre der Nutzer schützt, sodass hierfür kein Tracking mehr stattfinden muss, wie es bislang der Fall ist.

Der entscheidende Unterschied zwischen PPA und Tracking ist der, dass bei PPA der Browser die Kontrolle darüber hat, welche Informationen geteilt werden. Und wenn Werbetreibende auf diese Schnittstelle setzen, kann der Browser die Privatsphäre der Nutzer vollständig gewährleisten, was nicht möglich ist, wenn stattdessen auf Nutzer-Tracking gesetzt wird und die Browser-Maßnahmen gegen Tracking von Werbetreibenden bewusst umgangen werden.

Wie funktioniert PPA?

Die Funktionsweise von PPA ist, grob skizziert, dass der Browser Impressionen über eine Anzeige speichert, also wie oft diese angezeigt worden ist. Damit gespeichert werden auch weitere Informationen zur Anzeige, wie die Ziel-Website. Die Website gibt an, an welchen Anzeigen sie interessiert ist. Auf Grundlage dieser Angaben erstellt der Browser dann einen Bericht, gibt diesen aber nicht an die Website weiter. Stattdessen wird dieser verschlüsselt und anonym über das Distributed Aggregation Protocol (DAP) an einen Aggregationsdienst gesendet. Dieser Aggregationsdienst kombiniert diesen Bericht dann mit vielen weiteren Berichten. Darüber hinaus wird ein zusätzliches „Rauschen“ hinzugefügt, das für einen differentiellen Datenschutz sorgt.

Was kompliziert klingt, sorgt dafür, dass keine Browsing-Aktivitäten an irgendjemanden gesendet werden. Werbetreibende erhalten lediglich aggregierte Informationen zur Wirksamkeit ihrer Anzeigen.

Wer ist der Aggregationsdienst und was hat Let’s Encrypt damit zu tun?

Mozilla setzt als DAP-Partner auf die Internet Security Research Group, kurz: ISRG, welche als Aggregationsdienst für PPA dient. Wem die ISRG nichts sagt: Dahinter steckt niemand Geringeres als die Betreiberin von Let’s Encrypt. Also jene Organisation, der zig Millionen von Websites für ihre HTTPS-Zertifikate vertrauen, einschließlich dieses Blogs.

Wenn nun also PPA für ein so großes Vertrauensdefizit in Bezug auf Mozilla sorgt, wie es manche darstellen, dürfte für Let’s Encrypt als Produkt der ISRG nichts anderes gelten. Immerhin erhält diese die ganze Berichte vom Browser. Und wenn der ISRG und damit Let’s Encrypt nicht mehr vertraut wird, sollte man konsequenterweise vielleicht auch alle Websites meiden, welche ein Zertifikat von Let’s Encrypt verwenden. Alles andere wäre nicht konsequent.

Wieso PPA sogar eine realistische Chance haben könnte

Es gab schon viele Ansätze, das Problem von Werbung und Tracking zu lösen. Wieso sollte nun ausgerechnet PPA bessere Chancen haben? Die Antwort könnte in der Zusammenarbeit mit ausgerechnet einem der größten Werbeunternehmen der Welt liegen.

Wie bereits festgestellt, wird das Hinzufügen immer weiterer Anti-Tracking-Mechanismen nicht das grundsätzliche Problem lösen. Um dieses Problem zu lösen, ist es wichtig, genau zuzuhören, was die Anforderungen der Werbebranche sind, statt an deren Interessen vorbeizuarbeiten, damit die dann wieder die nächsten Schutzmaßnahmen umgehen.

Für die Entwicklung von PPA hat Mozilla mit Meta zusammengearbeitet, Betreiberin unter anderem von Facebook und Instagram und damit von zwei der weltweit größten Werbeplattformen, die sehr gerne ihre Nutzer tracken. Was auf den ersten Blick nach keinem guten Match klingt, ergibt viel Sinn: Denn wenn am Ende eine Lösung steht, mit der sogar Meta leben könnte, stehen die Chancen nicht schlecht, dass die Lösung auch für andere Werbedienstleister gut genug ist.

PPA betrifft nur Nutzer, die ohnehin Werbung sehen

Ein häufiges Argument in der ganzen Debatte ist, dass die Nutzer ja grundsätzlich gegen Werbung seien und sie deswegen auch gegen PPA sind. Was sie dabei übersehen: Da sie aus genau diesem Grund ja ohnehin einen Werbeblocker einsetzen, sehen sie auch keine Werbung und damit gibt es auch keine Attribution. Diese Nutzer betrifft es also überhaupt nicht. PPA betrifft aber alle Nutzer, die Werbung sehen – und verbessert deren Privatsphäre gegenüber Werbung, welche auf Tracking setzt. Daran gibt es nichts auszusetzen, wie man es auch dreht und wendet.

PPA verbessert die Privatsphäre – über Werbung hinaus

PPA kann aber auch die Privatsphäre über Anwendungsfälle der Werbung hinaus verbessern und betrifft damit dann doch wieder auch Nutzer, die keine Werbung sehen. Wie das?

Wie bereits besprochen, wird Tracking vor allem in Zusammenhang mit Werbung genutzt. Wenn sich nun eine datenschutzfreundliche Alternative zum Tracking etablieren würde und Werbetreibende hierfür nicht länger auf Tracking setzen würden, würde daraus auch folgen, dass die Browserhersteller daran arbeiten könnten, den Tracking-Schutz ihrer Browser schärfer zu stellen und noch mehr Tracking zu unterbinden. Denn während sich praktisch alle einig sind, dass Tracking schlecht für die Privatsphäre ist, ist das Interesse der Werbemessung ja durchaus legitim. Wenn dieser Anwendungsfall wegfällt, kann Tracking für andere Zwecke leichter identifiziert und blockiert werden und Schutzmaßnahmen, die jetzt vielleicht noch aus Webkompatibilitätsgründen nicht als Standard umgesetzt werden können, könnten es dann möglicherweise.

Wen betrifft das PPA-Experiment in Firefox 128 denn jetzt überhaupt?

Beim PPA-Experiment in Firefox 128 handelt es sich um eine sogenannte Origin Trial. Vor allem Nutzer von Google Chrome sollten das Konzept kennen, denn dort sind zahlreiche Origin Trials aktiv – denen der Nutzer übrigens auch nicht explizit zustimmt. Gleiches gilt für Microsoft Edge.

Doch was bedeutet das? Das bedeutet, dass die Schnittstelle nicht einfach so von jeder Website genutzt werden kann. Die Nutzung dieser Schnittstelle muss beim jeweiligen Browserhersteller beantragt werden.

Dies hängt damit zusammen, dass es in dieser Phase darum geht, überhaupt erst einmal festzustellen, ob PPA so funktioniert, wie man es sich erhofft, um mit diesen Erkenntnissen dann den entsprechenden Webstandard weiterzuentwickeln.

PPA ist nach aktuellem Stand nur für wenige Websites in den USA aktiv.

Muss PPA standardmäßig aktiviert sein?

Ein Kritikpunkt in der Debatte ist auch die standardmäßige Aktivierung von PPA. Ist das notwendig? Für mich ist das ein eindeutiges Ja. Ansonsten wäre die Antwort darauf, ob PPA eine Alternative zum Tracking werden kann, doch bereits vorweggenommen.

Tracking erfolgt nicht über eine Schnittstelle, die dediziert dafür da ist, die Nutzer zu verfolgen. Tracking erfolgt über ganz normale Webtechnologie, welche standardmäßig verfügbar ist. Müsste PPA, anders als so ziemlich jeder andere Webstandard, zunächst vom Benutzer aktiviert werden, könnte sich PPA auch nicht als Alternative zum Tracking etablieren, weil das Ergebnis dann zwansläufig deutlich unter dem wäre, was Tracking liefert. Außerdem verbessert eine standardmäßige Aktivierung von PPA auch deren Privatsphäre von dem Aspekt her, dass man keinen zusätzlichen Tracking-Vektor schafft, weil Nutzer mit aktiviertem PPA in einer Minderheit wären.

Als kurzzeitig angelegtes Experiment, welches nur auf wenigen Seiten aktiviert ist und wichtige Erkenntnisse zur weiteren Entwicklung des Standards liefern soll, wäre es außerdem nicht zielführend, wäre PPA nicht standardmäßig aktiviert. Denn um realistische Daten zu erhalten und damit eine Aussagekraft zu entwickeln, mit der man arbeiten kann, ist eine entsprechende Skalierung unabdingbar.

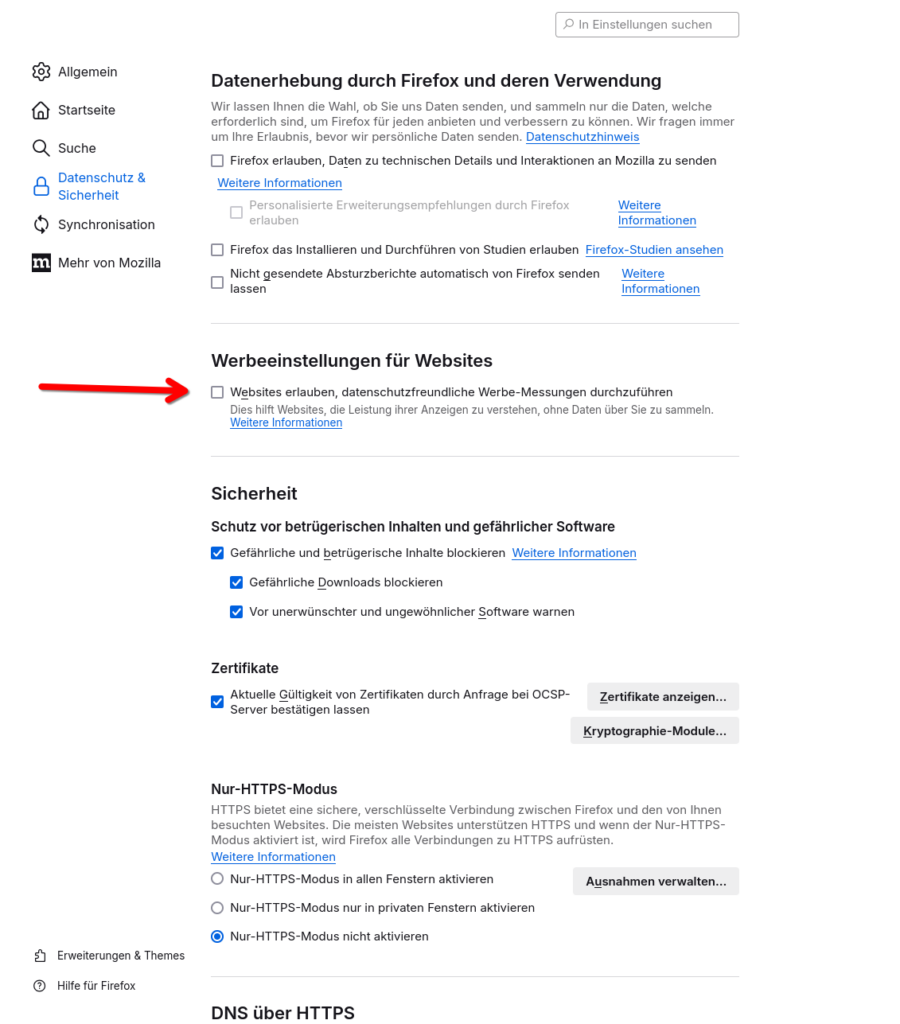

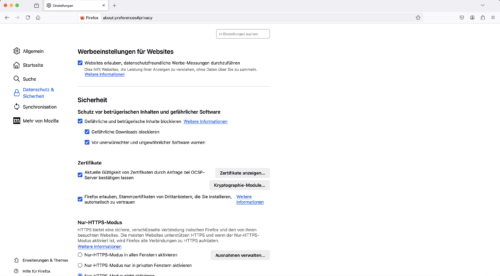

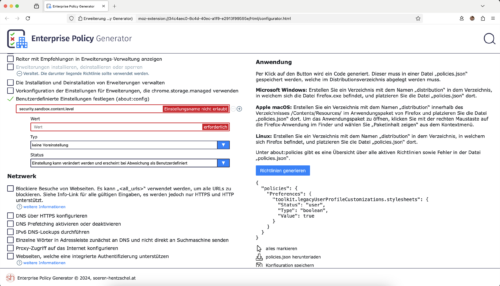

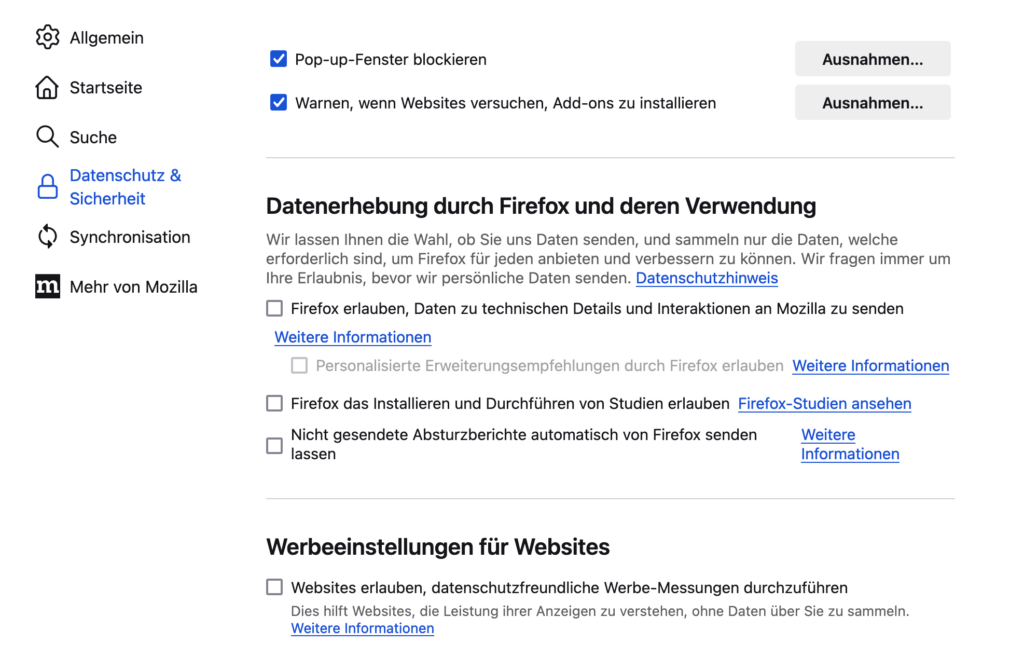

Und dennoch hat Mozilla seinen Nutzern in Firefox eine sichtbare Einstellung gegeben, um PPA zu deaktivieren. Etwas, was sie nicht hätten tun müssen, in Anbetracht dessen, dass auch die Webstandards, die für Tracking genutzt werden, nicht per Checkbox deaktivierbar sind.

Für Nutzer mit abgeschalteter Telemetrie ist PPA im Übrigen in jedem Fall auch inaktiv, unanbhängig von dieser Checkbox.

Alternative Ansätze nicht gut genug

Mozilla hat sich in den letzten Jahren auch ganz genau angesehen, wie alternative Vorschläge wie beispielsweise FLoC, die Topics API und Privacy Sandbox von Google funktionieren. Das Resultat war, dass diese Vorschläge die Privatsphäre nicht ausreichend schützen. Statt einfach nur zu kritisieren, hat Mozilla selbst aktiv daran gearbeitet, eine bessere Lösung zu finden. PPA ist das Ergebnis von Jahren der Recherche, Diskussion und Entwicklung, auch basierend auf Erfahrungen durch die Entwicklung von erfolgten Privatsphäre-Verbesserungen in Firefox und den Fehlern, die andere Vorschläge machten.

Angeblicher Zusammenhang mit Kauf eines „Werbeunternehmens“ ist gelogen, PPA bereits vor 2 1/2 Jahren angekündigt

Im Juni hatte Mozilla angekündigt, das Unternehmen Anonym gekauft zu haben. Anonym stellt Lösungen bereit, um den Erfolg digitaler Werbung in einer datenschutzfreundlichen Weise zu messen. Tatsächlich klingt das auf den ersten Blick sogar sehr zusammenhängend. Anonym stellt allerdings technische Lösungen auf Seiten der Werbedienstleister bereit. PPA geht das Thema von der Browserseite her an. Unbestritten ist, dass beide ein gemeinsames Ziel verfolgen.

Die Behauptung mancher Website, Anonym stecke hinter Mozillas Vorstoß mit PPA, ergibt überhaupt keinen Sinn. Denn Mozilla hat Privacy Preserving Attribution bereits im Februar 2022 angekündigt, also vor knapp 2 1/2 Jahren. Schon damals hatte Mozilla im Übrigen ausdrücklich um Feedback gebeten.

Eine solche Behauptung, die von Mozilla im Übrigen auch verneint wurde, kam beispielsweise von heise (keine Verlinkung, da Lügen nicht durch Backlinks belohnt werden sollten), wo man unverschämterweise sogar so weit ging, in den Raum zu werfen, Mozilla würde für die PPA-Integration – von wem auch immer – Geld erhalten. Selbstredend gab es weder für das eine noch das andere eine Quelle. Dies hat sich der Redakteur schlicht und ergreifend ausgedacht. Dies war auch nicht die einzige falsche Behauptung einer Seite, welche schon in der Vergangenheit immer wieder dadurch aufgefallen ist, dass gründliche Recherchen wohl eher nicht im Pflichtenheft der Redakteure stehen.

Kein Alleingang von Mozilla, W3C-Gruppe

PPA ist nichts, was Mozilla im Stillen für sich alleine entwickelt hätte. Bereits die Ankündigung im Februar 2022 verwies auf die Private Advertising Technology Community Group, eine Arbeitsgruppe innerhalb des World Wide Web Consortiums (W3C), wo sich Mozilla Feedback einholen konnte und kann. Deren Teilnehmerliste ist prominent bestückt, unter anderem mit anderen Browserherstellern wie Google, Microsoft, Apple und Samsung, aber auch mit Verlagen, Werbeunternehmen und anderen Tech-Unternehmen. Da sind wir nämlich wieder genau dort, wo wir bereits früher im Artikel waren: Eine nachhaltige Lösung muss alle beteiligten Parteien ins Boot holen.

Wenn PPA funktioniert, profitieren nicht nur Firefox-Nutzer davon

Mozillas Ziel war es immer, das Web als Plattform zu verbessern. Marktanteile von Firefox sind schön und natürlich auch wichtig, da ein hoher Marktanteil logischerweise auch die eigene Position verbessert, um Änderungen durchzusetzen. PPA ist aber ein Beispiel, bei dem es nicht nur um Firefox geht.

Innerhalb von Firefox kann Mozilla daran arbeiten, den Tracking-Schutz seines Browsers immer weiter zu verbessern. Davon profitieren dann natürlich ausschließlich Firefox-Nutzer. Wenn jedoch PPA in der Praxis tatsächlich funktioniert und Werbedienstleister nicht länger auf Tracking setzen müssten, kann es den Nutzern egal sein, welchen Browser sie nutzen, weil der Privatsphäre-Vorteil dann unabhängig vom Browser gegeben wäre.

Zu guter Letzt: Lest euch die Quellen immer selbst durch

Eine abschließende Bitte: Glaubt nicht alles, was irgendwelche Websites behaupten, egal wie groß deren Name ist. Stellt euch immer auch die Frage, was wohl die Motivation des jeweiligen Verfassers ist. Tatsache ist, dass ein großer Teil der Websites, die PPA in ein so schlechtes Licht rücken, eine auffällig hohe Anzahl an Tracking-Scripts laden, sprich selbst zu den größten Profiteuren Tracking-basierter Werbung zählen. PPA hingegen muss erst beweisen, dass es zu keiner Beeinträchtung der Einnnahmen-Situation für Verlage führen würde. Natürlich kann das auch nur Zufall sein und die Recherche zum Thema fand einfach nur auf unterirdisch schlechtem Niveau statt. So oder so gilt: Besser immer selbst die Quellen prüfen, egal bei welchem Thema.

Natürlich muss auch diesem Blog, der im Übrigen komplett werbefrei und zu 100 Prozent unabhängig (Spenden für eine Unterstützung unabhängiger und Fakten-basierter Berichterstattung gerne gesehen  ) betrieben wird, nicht blind vertraut werden. Einige Quellen dieses Artikels sind bereits direkt in den Artikel eingearbeitet. Am Ende möchte ich noch auf ein paar weitere offizielle Veröffentlichungen zum Thema in englischer Sprache hinweisen, für alle, die noch tiefer in das Thema einsteigen wollen:

) betrieben wird, nicht blind vertraut werden. Einige Quellen dieses Artikels sind bereits direkt in den Artikel eingearbeitet. Am Ende möchte ich noch auf ein paar weitere offizielle Veröffentlichungen zum Thema in englischer Sprache hinweisen, für alle, die noch tiefer in das Thema einsteigen wollen:

Der Beitrag Wieso Privacy Preserving Attribution (PPA) gut für die Privatsphäre der Nutzer ist erschien zuerst auf soeren-hentzschel.at.

) betrieben wird, nicht blind vertraut werden. Einige Quellen dieses Artikels sind bereits direkt in den Artikel eingearbeitet. Am Ende möchte ich noch auf ein paar weitere offizielle Veröffentlichungen zum Thema in englischer Sprache hinweisen, für alle, die noch tiefer in das Thema einsteigen wollen:

) betrieben wird, nicht blind vertraut werden. Einige Quellen dieses Artikels sind bereits direkt in den Artikel eingearbeitet. Am Ende möchte ich noch auf ein paar weitere offizielle Veröffentlichungen zum Thema in englischer Sprache hinweisen, für alle, die noch tiefer in das Thema einsteigen wollen: