Mozilla hat Firefox 115 für Windows, Apple macOS und Linux veröffentlicht. Dieser Artikel fasst die wichtigsten Neuerungen zusammen – wie immer auf diesem Blog weit ausführlicher als auf anderen Websites.

Download Mozilla Firefox für Microsoft Windows, Apple macOS und Linux

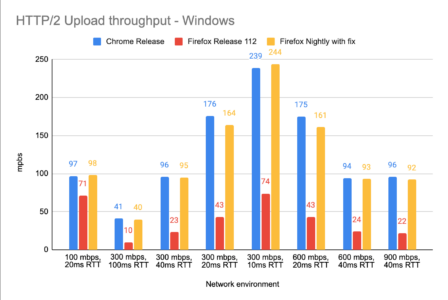

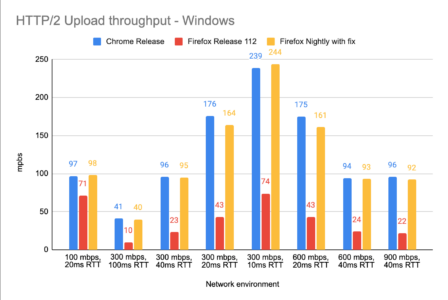

Verbesserungen der Netzwerkgeschwindigkeit

Die Geschwindigkeit, mit der Dateien auf Websites via HTTP/2 hochgeladen werden können, hat sich mit Firefox 115 signifikant verbessert.

Außerdem sorgt ein auf Betriebssystem-Ebene deaktivierter Standortdienst für Windows-Nutzer mit einigen WLAN-Treibern nicht länger für eine systemweite Netzwerk-Instabilität.

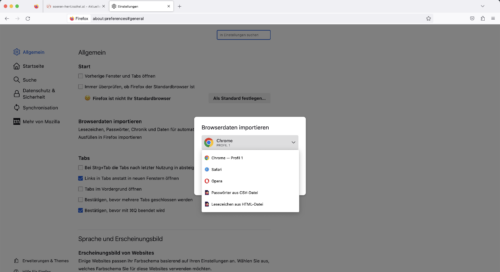

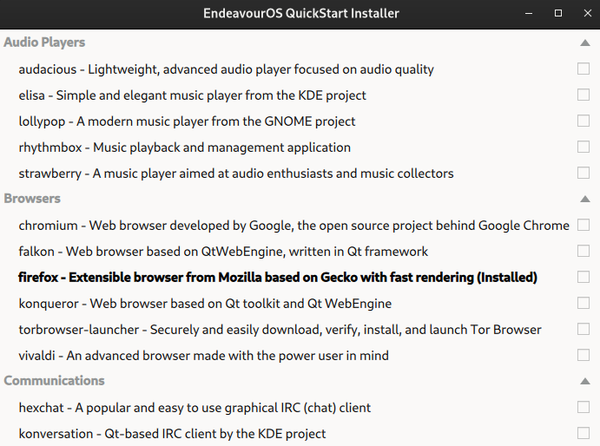

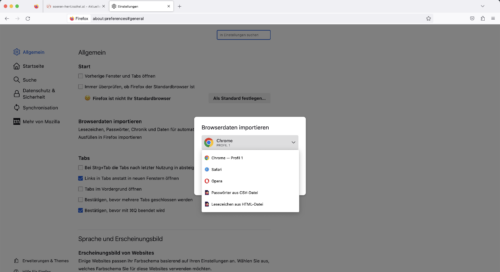

Verbesserter Import aus anderen Browsern

Der Import von Daten aus anderen Browsern wurde unter der Haube verbessert und erstrahlt auch optisch in neuem Glanz. Gespeicherte Kreditkartendaten lassen sich außerdem aus Chrome und anderen Chromium-basierten Browsern importieren, ebenso kann die Chronik aus Safari jetzt importiert werden.

Auch können im neuen Dialog HTML-Dateien für den Lesezeichen-Import ausgewählt werden. Ebenfalls ist darüber der Import von Passwörtern via CSV-Datei möglich, sofern signon.management.page.fileImport.enabled in about:config auf true steht. Für den Passwort-Import aus Safari, wo kein direkter Passwort-Import möglich wäre, ohne für jedes Passwort separat die Berechtigung hierfür anzufragen, werden Nutzer nach der Auswahl von Safari bei entsprechender Einstellung darum gebeten, eine aus Safari exportierte CSV-Datei auszuwählen.

Verbesserungen für die Wiedergabe von Videos

Das OpenH264-Plugin, welches bislang ausschließlich für WebRTC verwendet wurde, kann jetzt auch als Fallback-Codec für die Video-Wiedergabe verwendet werden, wenn kein H.264-Codec auf dem System installiert ist. Außerdem steht OpenH264 nun auch für Linux-Systeme mit ARM-CPU zur Verfügung.

Die Video-Wiedergabe unter Linux kann für Nutzer von Linux auf Systemen mit einer Intel-GPU jetzt durch die Hardware beschleunigt werden.

Sonstige Endnutzer-Neuerungen von Firefox 115

In der Auflistung aller Tabs (über das Pfeil-Symbol am Ende der Tableiste) besitzt nun jeder Tab eine Schließen-Schaltfläche, so dass man den jeweiligen Tab nicht länger aufrufen muss, um diesen zu schließen.

Die Funktionen Rückgängig und Wiederherstellen stehen jetzt auch in Eingabefeldern für Passwörter zur Verfügung.

Für Linux-Nutzer führt ein Mittelklick auf die Schaltfläche zum Öffnen eines neuen Tabs nun dazu, dass der xclipboard-Inhalt geöffnet wird. Handelt es sich dabei um eine URL, wird diese geöffnet, ansonsten eine Suche bei der eingestellten Standard-Suchmaschine durchgeführt.

Im Bild-im-Bild-Modus für Videos werden jetzt auch Untertitel für Videos von Sony Liv, TubiTV, Udemy und New York Times unterstützt. Außerdem kann der Bild-im-Bild-Modus jetzt auch für Videos ohne Audiospur genutzt werden.

Die sogenannten „Farbwelten“ waren eine zeitlich limitierte Sammlung von Themes, welche in Firefox beworben wurden. Nutzer, welches ein solches Theme noch nutzen und die automatische Update-Funktion für Erweiterungen deaktiviert haben, werden automatisch auf das entsprechende Theme auf addons.mozilla.org migriert, damit das Theme aktiv bleibt, sobald die entsprechenden Dateien aus Firefox entfernt werden.

Firefox unterstützt einen neuen Mechanismus, über welchen die Ausführung von Erweiterungen auf bestimmten Websites durch Mozilla, beispielsweise aus Sicherheitsgründen, verhindert werden kann.

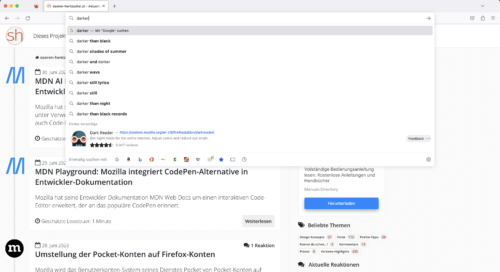

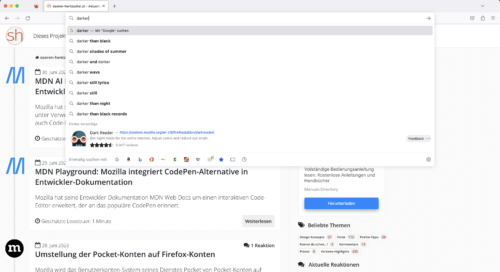

Ein weiterer neuer, aber noch nicht aktiver Mechanismus ermöglicht die Empfehlung bestimmter Erweiterungen bei Eingabe bestimmer Begriffe in die Adressleiste.

Ein Cache für die Firefox-Startseite beschleunigt die gefühlte Startgeschwindigkeit von Firefox für Nutzer, welche Firefox mit der Standard-Startseite starten.

Mehr Sicherheit für Firefox-Nutzer

Auch in Firefox 115 wurden wieder mehrere Sicherheitslücken geschlossen. Alleine aus Gründen der Sicherheit ist ein Update auf Firefox 115 daher für alle Nutzer dringend empfohlen.

Verbesserungen der Entwicklerwerkzeuge

In den Einstellungen der Entwicklerwerkzeuge gibt es eine neue Option, um das Öffnen eben dieser mittels F12-Taste zu deaktivieren.

Im Kompatibilitäts-Panel des Inspektor-Werkzeugs erscheint jetzt eine Versions-Angabe auf dem entsprechenden Browser-Icon.

Im Debugger ist es nun möglich, einzelne Zeilen eines Scripts zu deaktivieren.

Weitere Neuerungen der Entwicklerwerkzeuge werden im DevTools-Newsletter für Firefox 115 beschrieben.

Verbesserungen der Webplattform

Eine Verbesserung des contentEditable-Verhaltens sollte für eine verbesserte Kompatibilität mit dem Verhalten anderer Browser bei sogenannten WYSIWYG-Editoren sorgen.

IndexedDB-Datenbanken standen bisher nicht in privaten Fenstern zur Verfügung, was für Inkompatibilitäten mit einigen Websites sorgte, wenn Firefox in einem privaten Fenster genutzt wurde oder so konfiguriert war, dass grundsätzlich keine Chronik gespeichert wird, was einem permanenten privaten Modus entspricht. Firefox 115 unterstützt IndexedDB in privaten Fenstern. Hierbei werden die Daten verschlüsselt gespeichert und mit Beenden der Sitzung wieder gelöscht.

Die Verwendung von <link rel=“preconnect“> kann das Laden von Ressourcen beschleunigen. Diese Performance-Optimierung hat in Firefox bereits seit mehreren Jahren nicht mehr funktioniert und arbeitet ab Firefox 115 wieder korrekt.

Auf CSS-Seite neu ist die Unterstützung von animation-composition sowie supports-Bedingungen für @import-Regeln, auf JavaScript-Seite die Unterstützung von Array.fromAsync(). Außerdem werden die Methoden ab sofort unterstützt: Array.toReversed(), Array.toSorted(), Array.toSpliced(), Array.with(), TypedArrays.toReversed(), TypedArrays.toSorted() und TypedArrays.with().

URLSearchParams.has() und URLSearchParams.delete() unterstützen jetzt einen optionalen value-Parameter.

Die neue URL.canParse()-Funktion kann benutzt werden, um auf einfache und schnelle Weise zu prüfen, ob eine URL gültig ist und geparst werden kann. Ebenfalls neu ist die Response.json()-Funktion.

Für Entwickler von Firefox-Erweiterungen relevant ist die Unterstützung von storage.session sowie des commands.onChanged-Events. Außerdem ist die Manifest-Eigenschaft browser_style jetzt standardmäßig false für Manifest v3-Erweiterungen.

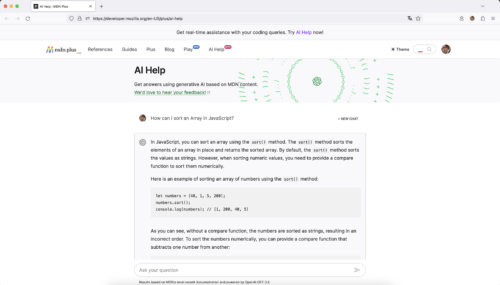

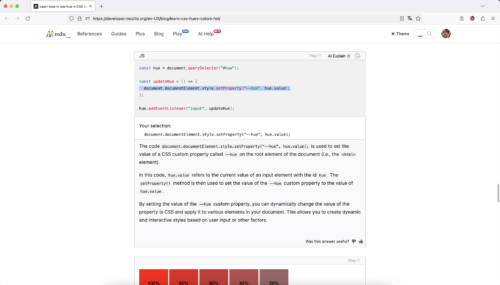

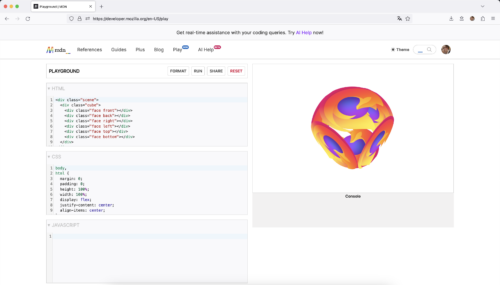

Weitere Neuerungen für Entwickler von Websites und Browser-Erweiterungen lassen sich in den MDN Web Docs nachlesen.

Neue Basis für Firefox ESR

Firefox 115 löst Firefox 102 als Basis für Firefox ESR, die Unternehmensversion von Firefox mit Langzeitunterstützung, ab. Bestehende Nutzer von Firefox ESR 102 werden am 26. September 2023 mit dem Erscheinen von Firefox ESR 115.3 automatisch auf Firefox ESR 115 umgestellt werden. Die Unterschiede zwischen Firefox 115 und Firefox ESR 115 sowie Wissenswertes für System-Administratoren werden in einem gesonderten Artikel behandelt.

Letzte Version für Windows 7/8, macOS 10.12/10.13/10.14

Bereits am 14. Januar 2020 hatte Microsoft die Unterstützung seines Betriebssystems Windows 7 offiziell eingestellt, die Einstellung der Unterstützung von Windows 8.1 folgte am 10. Januar 2023. Seitens Apple gibt es keine offiziellen Daten für Support-Enden, das letzte Update für macOS 10.14 erschien allerdings im Juli 2021. Dies ist für Nutzer insofern relevant, als dass es für diese Betriebssysteme keine Sicherheits-Updates mehr gibt. Nutzer sollten daher unbedingt auf ein aktuelles Betriebssystem umsteigen, falls noch nicht geschehen.

Firefox 115 ist das letzte große Update für diese veralteten Betriebssyssteme. Entsprechende Nutzer werden kommenden Monat mit Erscheinen von Firefox ESR 115.1 auf Firefox ESR 115 umgestellt und erhalten dann darüber noch bis September 2024 Sicherheits-Updates für Firefox. Neue Funktionen oder die Unterstützung für neue Webstandards gibt es allerdings keine mehr, Firefox 116 und höher wird auf diesen Systemen nicht mehr gestartet werden können.

Der Beitrag Mozilla veröffentlicht Firefox 115 erschien zuerst auf soeren-hentzschel.at.